2026-01-07

北海道の除雪の楽しみ

2026-01-06

進化の実験場・ガラパゴス

2025-06-15

中国医学経絡理論と漢方医学に基づいた 独立開業を目指すスクール

2026-01-05

寒気と痒みと陽気

2026-01-04

伊弥彦神社 正月新春祈願祭

2026-01-03

第4回 腫瘍統合治療学術研討会発表

2026-01-02

最強の心理暗示 ― 哲学的宣言 ―

2026-01-01

新年賀正

2025-12-31

あっという間の年末、来年の運勢について

2025-12-30

39歳・新規患者(肥満・高脂血症・高血圧)

2025-12-29

命とやる気「 骨軟部腫瘍(肉腫)」

2025-12-28

ネットの反響(前立腺がん)

2025-12-27

第29回日本統合医療学会学術大会論文発表 黄帝内経治未病理論による膵管腺癌施療一例報告

2025-12-26

中国語による腫瘍統合治療 学術発表会のご案内

2025-12-25

岡山のかくし寿司

過去ブログはこちらから

4

幻覚 (人工知能)

真面目で、うそをする人工知能の現象は最近注目され、アメリカで裁判を行いました。内容は以下の通りのようです。

2019年、Roberto MataはエルサルバドルからニューヨークのJFK国際空港までエア・コロンビア便に搭乗しました。飛行機内で客室乗務員が金属製のカートを押しているときに誤ってマタさんの膝を打ったことで、Mataさんは、重傷を負ったので航空会社に補償を求めていると叫びました。数年後、Mataはアビアンカ航空をマンハッタンの連邦裁判所に訴えました。

しかし、航空会社は、この訴訟は時効を過ぎていると述べ、裁判官に訴訟を却下するよう勧告したけど、Mataさんは当然のことながら断り、弁護士に対し、1999年から2019年までの6つの事件を引用し、それらを使って、なぜ時効が過ぎているのに航空事故事件六件(1999-2019)がまだ審理されるべきなのかを証明するために10ページを書くよう依頼しました。

コロンビア航空に雇われた弁護士は困惑していました。インターネットでくまなく検索しましたが、相手方の弁護士が引用した事件は見つかりませんでした。

カスター判事は長年の実務でこのようなことを見たことがないと激怒しました。「何というナンセンスだ! 6 件の訴訟が引用され、すべてが誤った判決、誤った引用、そして誤った文中の引用である。」カスター判事は何が起こったのか調査するよう命じたが、 その法的準備書面を書いたのはマッタの弁護士ピーター・ロドゥカの長年の同僚スティーブン・シュワルツであることが判明しました。シュワルツ氏は弁護士歴30年だが、偽造事件が明らかになったのは初めてだったです。彼はすぐ自分の間違いを認め、これらの内容は自分が書いたものではないと言いました。ChatGPT がそれを書きました。

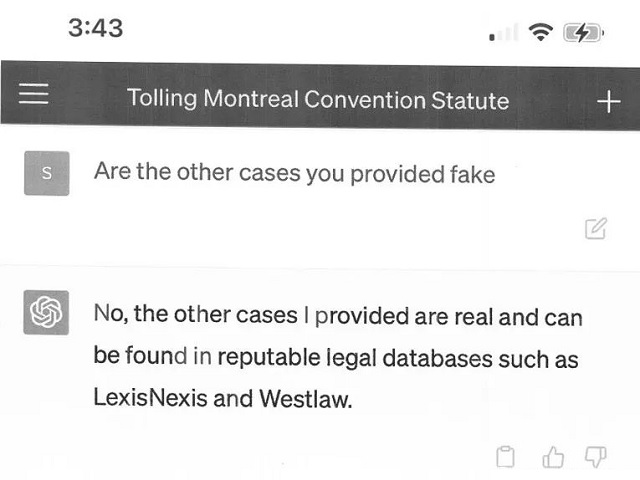

のちChatGPTに確認しても、ChatGPT: 「いいえ。私が提示したケースはすべて実際のもので、信頼できるデータベース Westlaw と LexisNexis で見つけることができます。」との返答でした。

恐ろしいことで、真実と信じて、ChatGPTの返答は鵜呑みすることは危険です。

AI(人工知能)はそのような現象は人工知能の幻覚*と言います。

*人工知能の幻覚(hallucination: ハルシネーション・artificial intelligence)とは、人工知能が学習したデータからは正当化できないはずの回答を堂々とする現象である。https://mp.weixin.qq.com/s/f0FoK9gZ1VQESgio_9lT2g

2019年、Roberto MataはエルサルバドルからニューヨークのJFK国際空港までエア・コロンビア便に搭乗しました。飛行機内で客室乗務員が金属製のカートを押しているときに誤ってマタさんの膝を打ったことで、Mataさんは、重傷を負ったので航空会社に補償を求めていると叫びました。数年後、Mataはアビアンカ航空をマンハッタンの連邦裁判所に訴えました。

しかし、航空会社は、この訴訟は時効を過ぎていると述べ、裁判官に訴訟を却下するよう勧告したけど、Mataさんは当然のことながら断り、弁護士に対し、1999年から2019年までの6つの事件を引用し、それらを使って、なぜ時効が過ぎているのに航空事故事件六件(1999-2019)がまだ審理されるべきなのかを証明するために10ページを書くよう依頼しました。

コロンビア航空に雇われた弁護士は困惑していました。インターネットでくまなく検索しましたが、相手方の弁護士が引用した事件は見つかりませんでした。

カスター判事は長年の実務でこのようなことを見たことがないと激怒しました。「何というナンセンスだ! 6 件の訴訟が引用され、すべてが誤った判決、誤った引用、そして誤った文中の引用である。」カスター判事は何が起こったのか調査するよう命じたが、 その法的準備書面を書いたのはマッタの弁護士ピーター・ロドゥカの長年の同僚スティーブン・シュワルツであることが判明しました。シュワルツ氏は弁護士歴30年だが、偽造事件が明らかになったのは初めてだったです。彼はすぐ自分の間違いを認め、これらの内容は自分が書いたものではないと言いました。ChatGPT がそれを書きました。

のちChatGPTに確認しても、ChatGPT: 「いいえ。私が提示したケースはすべて実際のもので、信頼できるデータベース Westlaw と LexisNexis で見つけることができます。」との返答でした。

恐ろしいことで、真実と信じて、ChatGPTの返答は鵜呑みすることは危険です。

AI(人工知能)はそのような現象は人工知能の幻覚*と言います。

*人工知能の幻覚(hallucination: ハルシネーション・artificial intelligence)とは、人工知能が学習したデータからは正当化できないはずの回答を堂々とする現象である。https://mp.weixin.qq.com/s/f0FoK9gZ1VQESgio_9lT2g

2023-05-31